イーロン・マスクがOpenAIを提訴したことを受けて、自身が経営するxAIのGrok-1がオープンソース化されました。これは実に驚くべきことなのです。OpenAIのGPTはオープンソース化していませんが、xAIはオープンソース化されました。イーロン・マスクは自身のX上で、「OpenAIのオープンな部分について教えてくれ」というような批判をしていたりします。

Grok-1とは?

Grok-1というのは、XAIが開発した大規模言語モデル、通称LLMと呼ばれるものです。このLLMについて説明しますと、OpenAIのGPTやAnthropicのClaude、GoogleのGeminiなどのように、膨大な量のテキストデータで訓練された人工知能モデルのことをLLMと呼びます。ChatGPTのような自然な会話ができるのはLLMが動作しているからです。

今回のGrok-1は、文章生成、翻訳、要約などが得意なLLMとなっています。性能としては、数学と推論の能力を計測するベンチマークテストでGPT-3.5やLLaMA-2を上回るスコアを出しています。ただし、GPT-4やClaudeには及ばないようです。

2023年11月にxAIが発表したGrokというAIチャットボットがありますが、そこでも使われているのがこのGrok-1という言語モデルです。ここからはAIチャットボットGrokの特徴についても紹介していきましょう。

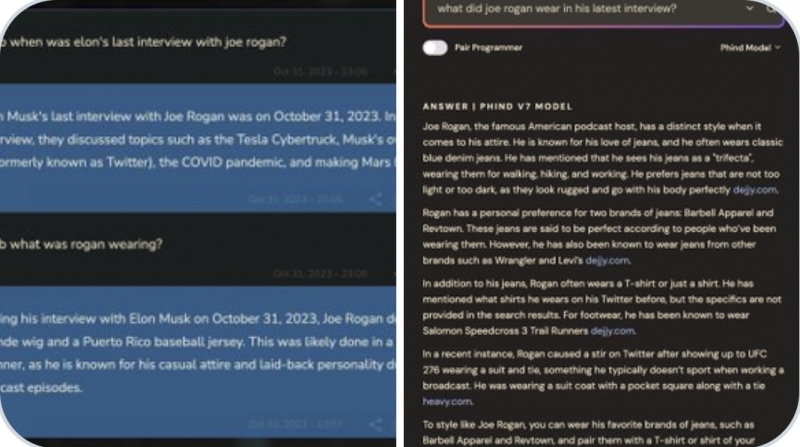

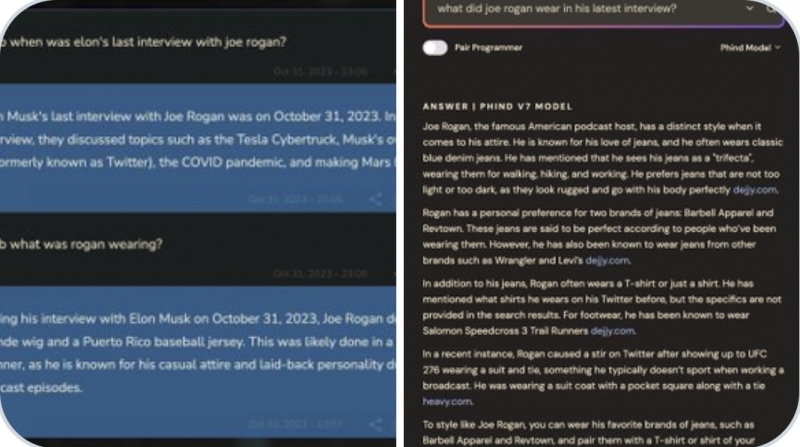

Grokは最新情報を取り入れ、それに基づいた回答ができるAIチャットボットです。このAIは他のAIが回答を避けるようなセンシティブな質問にも答えることができ、ウィットに富んだ答え方をするよう設計されているそうです。具体的には、GPTやClaudeが適切に答えてくれないようなドラッグや宗教などについての質問にも、回答を避けずに上手に対応してくれるようです。これはイーロン・マスクの思想に由来しており、どんな話題でも制限なく自由に発言できるべきだという考え方によるものでしょう。

オープンソース化とは?

オープンソース化とは、ソフトウェアのソースコード(プログラムの核となる部分)を無償で一般公開することを指します。つまり、世界中の誰もがGrok-1を使ったり、改良したり、再配布したりできるようになったのです。今回オープンソース化されたのは、Grok-1がどのような構成で作られているかという内容と、モデルが学習した知識を数値化した「モデルの重み」というデータです。

オープンソース化のメリットとしては、世界中の研究者がソースコードを閲覧できるようになるため、改良や新たなAI開発のスピードが上がり、性能の向上が期待できます。一方でデメリットとしては、不正利用のリスクや、開発の一貫性が失われる可能性などが挙げられます。ただ総じて言えば、AIの技術発展と普及のメリットの方が大きいと考えられています。

冒頭でも述べた通りイーロン・マスクはOpenAIを提訴しています。その理由は、OpenAIが営利に走り、GPT-4などをオープンソース化していないことが契約違反に当たるのではないかというものです。今回のGrok-1のオープンソース化は、OpenAIとの戦いで有利に働くのではないかと言われています。OpenAIはオープンソース化していないが、xAIはオープンソース化したということですね。

イーロン・マスクとOpenAIの関係性

ここで、イーロン・マスクとOpenAIの関係性について振り返ってみましょう。2023年4月のFox Newsのインタビューで、イーロン・マスクはAIチャットボットを開発中だと語っていました。当時はGrokという名前ではなく、「Telus GPT」と呼ばれていたようです。そしてxAIが設立されたのが2023年7月13日です。xAIのAI開発の目的は「宇宙の真の性質を理解すること」だそうです。一方、OpenAIのAI開発の目的は「AGIが全人類に利益をもたらすようにすること」、Googleは「人々と社会に役立つ利益をもたらすこと」となっています。つまり、xAIとOpenAIやGoogleではAI開発の目的が大きく異なるということです。

イーロン・マスクはオープンソース研究の提唱者であり、Twitterを買収した後にはアルゴリズムのソースコードをオープンソース化したり、Tesla社の特許を公開したりしています。一方、現在のOpenAIとは方向性が合わなくなっており、2018年ごろにOpenAIを離脱しています。そして数年後の今、イーロン・マスクはOpenAIを提訴するに至ったのです。

Grok-1のオープンソース化後、イーロン・マスクはX上でChatGPTのアカウントに対し、「OpenAIのオープンな部分を教えてくれ」と批判的なメッセージを送っています。ちなみに、営利目的の事業を行っているのはOpenAIではなくOpenAI Globalという別会社です。とはいえ、外部から見れば、OpenAIもOpenAI Globalも同じように見えるでしょう。オープンを掲げる割に、オープンでない部分があるのは問題だと言いたくなる気持ちはわかります。

Grok-1の特徴として、パラメータ数が3,140億と非常に大きいことが挙げられます。比較として、Meta社のLLaMA-2は700億パラメータ、GPT-3は1,750億パラメータとなっています。つまりGrok-1は、現在オープンソース化されている言語モデルの中で最大級のものだと言えます。パラメータ数が多いほど、モデルの複雑さが増し、高度な文章生成や推論が可能になります。ただし、計算コストとメモリ使用量も跳ね上がるため、一般的なPCでは動作させるのが難しくなります。

Grok-1は、「MOE(Mixture of Expert Model)」という構成を採用しています。MOEでは、一つの巨大なモデルを使うのではなく、複数の小さな専門家モデルを組み合わせて使います。例えば数学や文章作成、対話などの分野に特化した専門家モデルを、タスクに応じて適切に組み合わせるのです。こうすることで、開発と運用の効率化、コスト削減などのメリットが得られます。

Grok-1とは?

Grok-1というのは、XAIが開発した大規模言語モデル、通称LLMと呼ばれるものです。このLLMについて説明しますと、OpenAIのGPTやAnthropicのClaude、GoogleのGeminiなどのように、膨大な量のテキストデータで訓練された人工知能モデルのことをLLMと呼びます。ChatGPTのような自然な会話ができるのはLLMが動作しているからです。

今回のGrok-1は、文章生成、翻訳、要約などが得意なLLMとなっています。性能としては、数学と推論の能力を計測するベンチマークテストでGPT-3.5やLLaMA-2を上回るスコアを出しています。ただし、GPT-4やClaudeには及ばないようです。

2023年11月にxAIが発表したGrokというAIチャットボットがありますが、そこでも使われているのがこのGrok-1という言語モデルです。ここからはAIチャットボットGrokの特徴についても紹介していきましょう。

Grokは最新情報を取り入れ、それに基づいた回答ができるAIチャットボットです。このAIは他のAIが回答を避けるようなセンシティブな質問にも答えることができ、ウィットに富んだ答え方をするよう設計されているそうです。具体的には、GPTやClaudeが適切に答えてくれないようなドラッグや宗教などについての質問にも、回答を避けずに上手に対応してくれるようです。これはイーロン・マスクの思想に由来しており、どんな話題でも制限なく自由に発言できるべきだという考え方によるものでしょう。

オープンソース化とは?

オープンソース化とは、ソフトウェアのソースコード(プログラムの核となる部分)を無償で一般公開することを指します。つまり、世界中の誰もがGrok-1を使ったり、改良したり、再配布したりできるようになったのです。今回オープンソース化されたのは、Grok-1がどのような構成で作られているかという内容と、モデルが学習した知識を数値化した「モデルの重み」というデータです。

オープンソース化のメリットとしては、世界中の研究者がソースコードを閲覧できるようになるため、改良や新たなAI開発のスピードが上がり、性能の向上が期待できます。一方でデメリットとしては、不正利用のリスクや、開発の一貫性が失われる可能性などが挙げられます。ただ総じて言えば、AIの技術発展と普及のメリットの方が大きいと考えられています。

冒頭でも述べた通りイーロン・マスクはOpenAIを提訴しています。その理由は、OpenAIが営利に走り、GPT-4などをオープンソース化していないことが契約違反に当たるのではないかというものです。今回のGrok-1のオープンソース化は、OpenAIとの戦いで有利に働くのではないかと言われています。OpenAIはオープンソース化していないが、xAIはオープンソース化したということですね。

イーロン・マスクとOpenAIの関係性

ここで、イーロン・マスクとOpenAIの関係性について振り返ってみましょう。2023年4月のFox Newsのインタビューで、イーロン・マスクはAIチャットボットを開発中だと語っていました。当時はGrokという名前ではなく、「Telus GPT」と呼ばれていたようです。そしてxAIが設立されたのが2023年7月13日です。xAIのAI開発の目的は「宇宙の真の性質を理解すること」だそうです。一方、OpenAIのAI開発の目的は「AGIが全人類に利益をもたらすようにすること」、Googleは「人々と社会に役立つ利益をもたらすこと」となっています。つまり、xAIとOpenAIやGoogleではAI開発の目的が大きく異なるということです。

イーロン・マスクはオープンソース研究の提唱者であり、Twitterを買収した後にはアルゴリズムのソースコードをオープンソース化したり、Tesla社の特許を公開したりしています。一方、現在のOpenAIとは方向性が合わなくなっており、2018年ごろにOpenAIを離脱しています。そして数年後の今、イーロン・マスクはOpenAIを提訴するに至ったのです。

Grok-1のオープンソース化後、イーロン・マスクはX上でChatGPTのアカウントに対し、「OpenAIのオープンな部分を教えてくれ」と批判的なメッセージを送っています。ちなみに、営利目的の事業を行っているのはOpenAIではなくOpenAI Globalという別会社です。とはいえ、外部から見れば、OpenAIもOpenAI Globalも同じように見えるでしょう。オープンを掲げる割に、オープンでない部分があるのは問題だと言いたくなる気持ちはわかります。

Grok-1の特徴として、パラメータ数が3,140億と非常に大きいことが挙げられます。比較として、Meta社のLLaMA-2は700億パラメータ、GPT-3は1,750億パラメータとなっています。つまりGrok-1は、現在オープンソース化されている言語モデルの中で最大級のものだと言えます。パラメータ数が多いほど、モデルの複雑さが増し、高度な文章生成や推論が可能になります。ただし、計算コストとメモリ使用量も跳ね上がるため、一般的なPCでは動作させるのが難しくなります。

Grok-1は、「MOE(Mixture of Expert Model)」という構成を採用しています。MOEでは、一つの巨大なモデルを使うのではなく、複数の小さな専門家モデルを組み合わせて使います。例えば数学や文章作成、対話などの分野に特化した専門家モデルを、タスクに応じて適切に組み合わせるのです。こうすることで、開発と運用の効率化、コスト削減などのメリットが得られます。